珠联璧合:NVIDIA与VMware联合发布AI就绪型企业级平台

【慧聪通信网】由于企业纷纷通过对数据中心进行现代化升级来为AI应用和数据科学提供支持,NVIDIA和VMware大幅简化了现代混合云中各种不同AI工作负载的开发和部署。

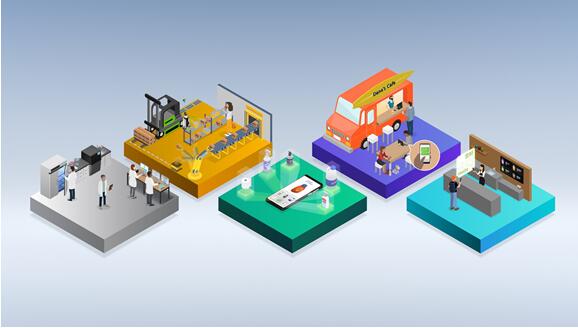

两家公司联合使用NVIDIA AI Enterprise软件套件对刚刚发布的vSphere更新——VMwarevSphere7Update2进行了AI应用优化(见下图1)。对于数十万家使用vSphere实现计算虚拟化的企业而言,这一组合为他们的大量加速CUDA应用、AI框架、模型和SDK实现了扩展性、多节点性能和兼容性。

通过此次业内首创的合作,AI研究人员、数据科学家和开发者获得了成功交付AI项目所需的软件,而IT专业人员能够使用他们最熟悉的大规模数据中心管理工具为AI提供不折不扣的支持。

图1:用于VMware vSphere的NVIDIA AI Enterprise在NVIDIA认证系统上运行,使IT部门能够轻松地大规模部署虚拟化AI。

完整齐全的企业级AI套件

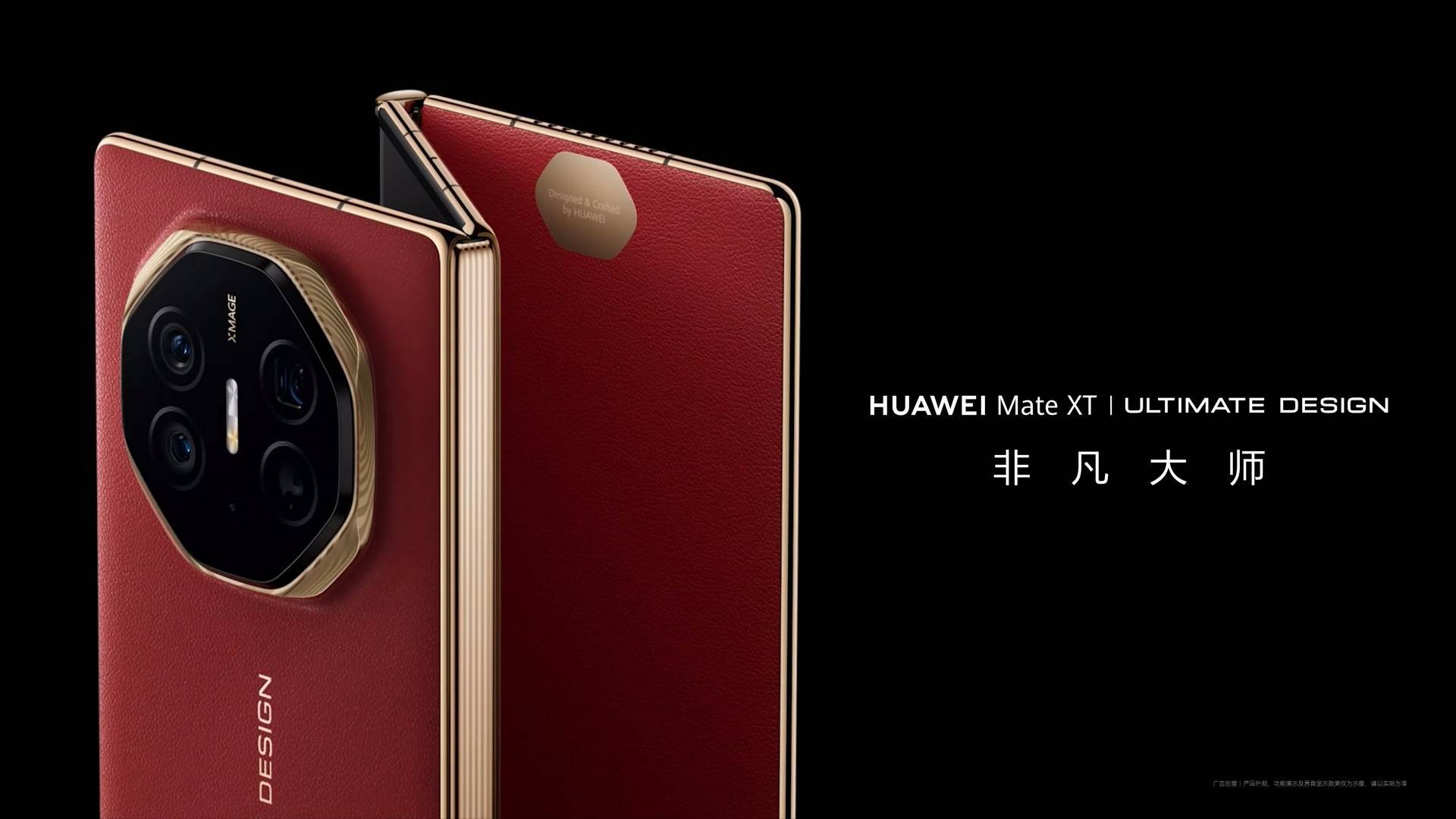

NVIDIA AI Enterprise是一套完整齐全的企业级AI工具和框架,它能够帮助制造、物流、金融服务、零售和医疗健康等众多关键行业优化业务流程、提升效率。凭借NVIDIA AI Enterprise,科学家和AI研究人员可以轻松访问NVIDIA领先的AI工具,推动高级诊断、智能工厂、欺诈检测等项目的AI发展。

该解决方案解决了部署单个AI应用的复杂性问题,以及由于必须手动配置和管理各种不兼容的应用和基础设施软件而可能导致的潜在故障。

凭借在vSphere上运行的NVIDIA AI Enterprise,客户可以避免难以管理和不安全的AI专用系统孤岛。同时,还可以降低部署shadowAI(即数据科学家和机器学习工程师在IT生态系统之外采购资源)的风险。

在获得NVIDIA许可证后,AIEnterpriseforvSphere可在NVIDIA认证系统上得到支持。获得NVIDIA认证系统认证的服务器包括戴尔科技、新华三、慧与、浪潮、联想和超微等高容量服务器。即便是最先进、要求最严苛的AI应用,也能像传统企业工作负载一样,在通用基础设施上通过VMwarevCenter等数据中心管理工具轻松获得支持。

IT部门可以管理可用性、优化资源分配,并在本地和混合云中运行的AI工作负载保障其宝贵的IP和客户数据的安全。

可扩展多节点虚拟化AI性能

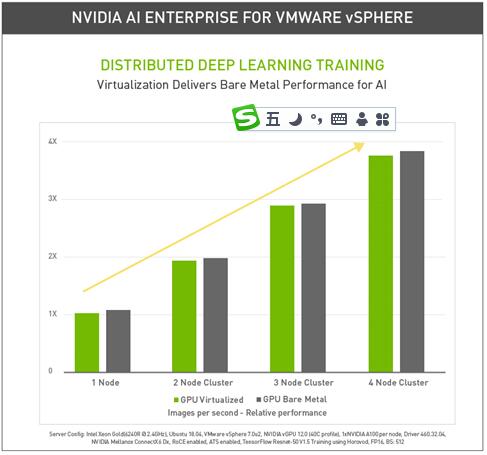

NVIDIA AI Enterprise使虚拟工作负载能够在vSphere上以接近裸金属的性能运行,并通过NVIDIA A100 GPU在AI和数据科学领域获得突破性性能(见下表1)。现在,AI工作负载可以扩展到多个节点,即便是具有完整GPU虚拟化的最大规模的深度学习训练模型也可以在VMware Cloud Foundation上运行。

表1:用于vSphere的NVIDIAAIEnterprise使分布式深度学习训练可线性扩展至多个节点,并提供与裸机完全相同的性能。

AI工作负载规模不一,对数据的要求也不尽相同。有些需要处理图像,例如实时流量报告系统或网上购物推荐系统等;另一些则基于文本,比如由对话式AI驱动的客户服务支持系统等。

训练一个AI模型需要使用的数据量可能令人难以置信,而且需要在多个节点的多个GPU上扩展性能。在部署中的模型上运行推理所需的计算资源一般较少,并且可能不需要用到整个GPU的性能。

NVIDIA与VMware一起将vSphere打造成唯一一款通过NVIDIA多实例GPU(MIG)技术为实时迁移提供虚拟机监视器支持的计算虚拟化软件。凭借MIG技术,每个A100GPU可以在硬件层面被分割成多至7个实例,从而最大限度地提高各种规模工作负载的效率。

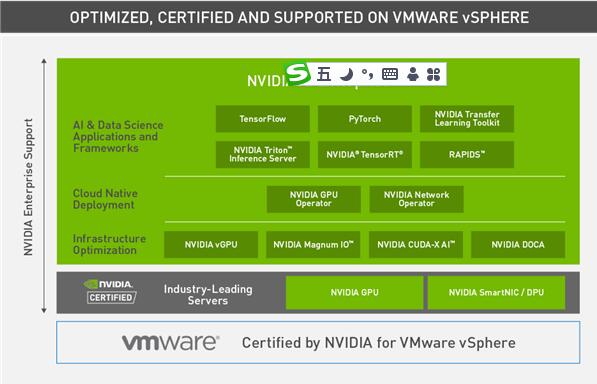

丰富的AI应用和基础设施资源

NVIDIA AI Enterprise包含了NVIDIA的关键技术和软件。通过它们,可以在VMware Cloud Foundation上运行的虚拟化数据中心中快速部署、管理和扩展AI工作负载。

NVIDIA AI Enterprise是一款经过认证的端到端套件,包含了NVIDIA的关键AI技术、应用及企业支持服务。

预计在升级到vSphere 7U2时采用NVIDIA AI Enterprise的客户,可以联系NVIDIA和VMware提出需求。